Мы свяжемся с вами в ближайшее время!

Разом з розвитком сайту посилюється боротьба з внутрішніми дублями і наявністю низькоякісних, з точки зору пошукових систем, сторінок.

Неправильно налаштовані сторінки пагінації втрачають цінність для пошукових систем, через те, що є частковими або повними дублями.

У даній статті ми розглянемо основні помилки в налаштування пагінації, а також - актуальні робочі стратегії налаштування, які застосовують великі інтернет-магазини, онлайн-портали та дошки оголошень.

Пагінація - мало не найбільший головний біль фахівця під час SEO сайтів, особливо великих або стрімко зростаючих. Основна проблема - наявність дубльованих сторінок, яка призводить до того, що сайт скочується на "гальорку" пошукової видачі практично без шансів вибитися в дамки. На наявність таких сторінок вказують дублікати за Title і копіювання тексту в межах одного ресурсу.

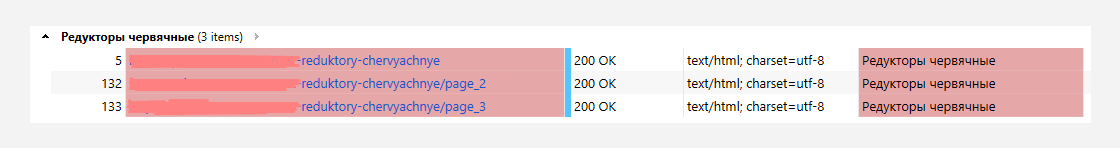

Шукаємо дублікати Title у Netpeak Spider або Comparser.

За допомогою ефективних інструментів SEO-аналізу Netpeak Spider або Comparser досліджуємо сайт і сортуємо результати за дублікатами Title.

Опрацьовуємо результати, які дублюються за тегом Title і відшукуємо URL сторінок пагінації (/ page / 2 /, /? рage = 2 і так далі).

Шукаємо тексти-дублі в межах ресурсу.

Поширена помилка пагінації - відображення одного і того ж тексту на всіх її сторінках. Це призводить до утворення внутрішніх дублікатів. Виявити їх можна кількома способами:

| за допомогою сканування унікальності через сервіс Advego; | |

| в ручному режимі: відкриваємо кожну сторінку і скрупульозно шукаємо повторювані тексти. |

Коли помилки на сайті визначені, можна приступати до налаштування. Головне, зробити це правильно, використавши найбільш ефективні методи, що відповідають актуальним вимогам пошукових систем.

Раніше вони були офіційними сигналами для пошукового бота і значилися в офіційній довідці, поряд з довідкою з використання rel canonical в Google рекомендаціях.

Після оновлення представники компанії заявили наступне: "Ми звернули увагу, що вже декілька років не використовуємо rel next і rel prev в операціях індексації, тому вся документація з офіційної довідки щодо цих атрибутів була видалена".

Яка ж стратегія пропонується компанією замість видалених? Google рекомендує фахівцям розміщувати всі позиції на одній сторінці, якщо це можливо, і при цьому запевняє, що проблем з індексацією розмітки не буде.

«Використовуйте розмітку. Пошуковий робот Google досить розумний для того, щоб відшукати наступну сторінку, скануючи посилання на сторінці. І очевидні сигнали, які використовувалися раніше, нам більше не потрібні. Звичайно, ви можете додавати атрибути next і prev з інших важливих причин, однак Google це більше не потрібно», — додали представники компанії.

Отже, чого ми НЕ робимо при pagination SEO, щоб не допустити помилок:

| не закриваємо всі сторінки в robots.txt; | |

| не встановлюємо rel = "canonical" на першу сторінку з усіх сторінок розмітки. |

Доречі, деякі ресурси пропонують ці стратегії, як дієві заходи для боротьби з дублікатами. І вони абсолютно праві! Дублів ви, швидше за все, позбудетеся. Однак, ви також отримаєте проблеми з індексацією статей або товарів. І ось чому.

У першому випадку через приховування розмітки в robots.txt пошуковий бот відвідає тільки першу сторінку пагінації і на цьому зупиниться.

У другому випадку бот буде ігнорувати пагінацію, так як через rel = "canonical" ми встановили, що наступні сторінки є копіями канонічної.

Отже, ми розглянули головні помилки SEO пагінації, що стосуються canonical, next і prev, robots.txt і розповіли, як робити не можна. Зазвичай на перерахуванні помилок безкоштовні рекомендації фахівців закінчуються. Мовляв, хочете знати як ПОТРІБНО робити - купіть наш інфопродукт. Але ми не жадібні і робочими стратегіями налаштування пагінації поділимося за спасибі.

| 1. |

Meta robotsНа всі сторінки розмітки ставимо тег <meta name="robots" content="noindex, follow" /> |

| 2. |

Добиваємося максимальної унікальності кожної сторінкиКожній сторінці - свій title, description, і текстове наповнення; |

| 3. |

Сторінка «Дивитися все» спільно з rel = "canonical"Крім pagination-сторінок створюється сторінка "Дивитися все", на якій розміщуються всі товарні позиції категорії. У свою чергу, з усіх pagination-сторінок встановлюємо rel = "canonical", та робимо "Дивитися все" канонічною: |

Для того, щоб зрозуміти, які стратегії та наскільки успішно працюють на практиці, відкриємо завісу SEO-налаштування великих онлайн-ресурсів і подивимося яку стратегію для пагінації обирають для них:

Отже, що ми бачимо. Жоден сайт не використовує стратегію з відображенням усіх товарів на сторінці "Всі товари" або "Дивитися все". Близька половини не закривають сторінки для пошукових роботів, працюючи над унікальністю метаданих.

Інша половина обмежує доступ для індексування наступних за канонічним посиланням сторінок, але дозволяють роботам "гуляти" по ним. Вони ж часто використовують "сигнальні" атрибути prev і next, домагаючись кращого індексування на віддалених сторінках.

Окремі сайти і зовсім вирішили повністю обмежити можливість індексації сторінок, що, швидше за все, закінчується проблемами з індексацією товарів на них.

Розглянемо стратегію налаштування розмітки сторінок, яку можна вважати, якщо не ідеальною, то у всякому разі дієвою. Доведено власним досвідом та шляхом дослідження поведінки великих сайтів в Мережі. Така стратегія підійде, в першу чергу, для пагінації інтернет-магазинів, так як їх власники найбільш зацікавлені в нормальній індексації товарів на сторінках розмітки.

Отже, ось список основних правил і дій.

Правило перше: забудьте про закриття сторінок в robots.txt

Інакше, проблем з індексацією сторінок, на яких розміщені ваші товари, не уникнути.

Адреси сторінок пагінацію повинні відрізнятися один від одного.

Приклад:

| http://site.ua/category | Адреса категорії |

| http://site.ua/category?page=2 | Адреса 2-ї сторінки |

| http://site.ua/category?page=3 | Адреса 3-ї сторінки |

Дія перша: забороняємо пошуковим роботам додавати сторінки від 2-й і далі в індекс, не перешкоджаючи при цьому вільному пересуванню бота цими сторінками. Для цього у вихідному коді цих сторінок додаємо рядок коду в тілі тегу <head>. Виглядає це наступним чином:

<head> ... <meta name="robots" content="noindex, follow" /> ... </head>

Першої сторінки розмітки не повинно існувати. Як правило вона існує у якості дублю категорії. Для вирішення завдання ми рекомендуємо налаштувати редирект 301 з першої сторінки розмітки на сторінку категорії.

Приклад:

| <strong>http://site.ua/category/<strong> | URL категорії |

| http://site.ua/category?page=1 | URL першої стр-ки на якій налаштовуємо 301 редирект на http://site.ua/category |

Отже, пагінація - це необхідний механізм організації веб-ресурсу, який позитивно впливає на його юзабіліті. При цьому, переважна більшість великих сайтів надають перевагу стандартній розмітці з канонічним посиланням, та не використовують стратегію відображення View All.

Справа в тому, що відкриття великої кількості сторінок у View All сильно перевантажує сайт, призводить до надмірно довгого завантаження і змушує відвідувачів покинути його.

Для максимально ефективного налаштування пагінації, при якому пошукові боти зможуть вільно пересуватися сторінками, але не стануть включати їх в індекс, ми пропонуємо використовувати наведену вище стратегію.

Вона підійде як для інтернет-магазинів, так і, наприклад, для пагінації в WordPress (іноді може знадобитися установка плагіну для пагінації, якщо в шаблоні його немає за замовчуванням).

Під час налаштування слід враховувати нові правила від Google. Рекомендації від Яндекс в останні кілька років не змінювалися.

Мы свяжемся с вами в ближайшее время!

Ми зв'яжемося з вами найближчим часом!