Мы свяжемся с вами в ближайшее время!

Деякі помилки в SEO - критичні. Вони зводять нанівець всі зусилля з пошукового просування. Одна з таких помилок - дубльовані сторінки. Пропущені оптимізатором клони вкрай негативно сприймаються пошуковими системами та скочують сайт на задвірки видачі. Тому так важливо виявити дублі вже на перших етапах SEO перевірки сайту і швидко їх усунути. Як це зробити - розповімо в сьогоднішній статті.

Дублі - це різні сторінки сайту з унікальними URL, контент яких повністю або частково збігається.

В межах одного ресурсу можуть перебувати такі типи дублів:

Більшість оптимізаторів розглядають два основних типи SEO дублів сторінок - повні і часткові дублі.

Це абсолютні клони, сторінки з повністю ідентичним вмістом, доступні за унікальним веб-адресами.

Це можуть бути:

И так далі.

Часткове дублювання контенту на сайті - це сторінки, які повторюють частину вмісту інших, але не є абсолютними клонами. Причиною їх виникнення найчастіше стають особливості системи управління сайтом.

Найчастіше частковими клонами виступають:

В такому випадку пошук дублів сторінок дещо ускладнюється. При цьому наслідки їх наявності мають системний характер і погано відбиваються на позиціях у видачі. Як саме? Розглянемо далі.

Наслідками великої кількості клонів стають:

Одне з основних вимог пошукових систем до сайтів: одна сторінка = одна URL-адреса = унікальний контент на сторінці. Дублі руйнують цю формулу. Тому, щоб уберегти сайт від втрати трафіку та існування на задвірках видачі, важливо перевірити сайт на повторювані посилання і дубльований контент вже на першому етапі оптимізації та по ходу просування. Як це зробити – розповімо далі.

Ось кілька ефективних методів пошуку дублів:

Отже, як перевірити сайт на дублі сторінок за допомогою ручного моніторингу? Вводимо в рядку пошуку запит в такій формі:

site: назва ресурсу пробіл фрагмент тексту

Обсяг введеного тексту не повинен перевищувати одне речення, яке не повинне закінчуватися крапкою.

У відповідь на запит з'являться всі сторінки з цим текстом на вашому ресурсі. Виявити повні дублі допоможе текст сніпету: якщо фраза з запиту виділена жирним шрифтом у двох і більш сніпетах з видачі - значить дублі мають місце.

Google Search Console допоможе виявити дублі сторінок з ідентичними мета-описами і заголовками TITLE. Для цього необхідно перейти на вкладку «Оптимізація» - «Оптимізація HTML». Так ми отримуємо список потенційних клонів.

Найчастіше перевірка дублів сторінок пошуковими оптимізаторами здійснюється за допомогою наступних онлайн сервісів:

Розглянемо специфіку роботи з кожним із сервісів.

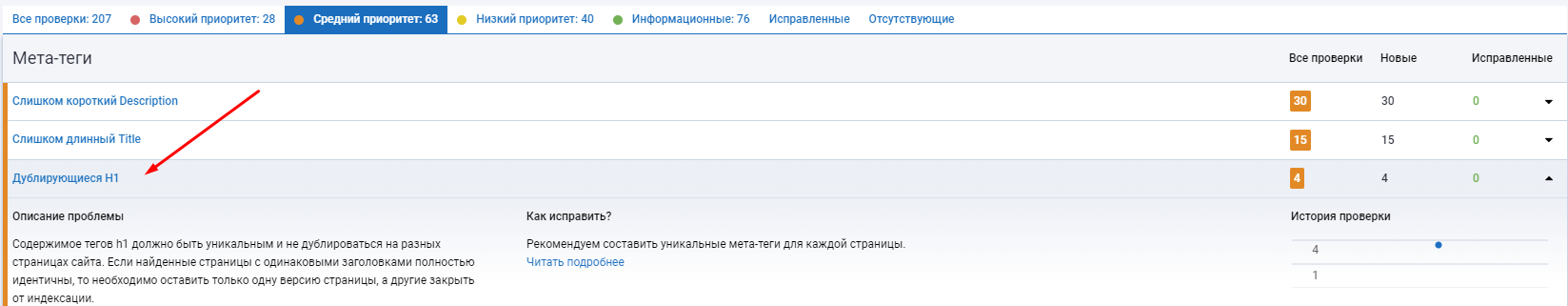

За допомогою сервісу можна провести технічний SEO-аудит ресурсу і виявити більше 20-ти типів помилок. У їх числі - пошук дубльованого контенту на двох і більше сторінках. Платформа виявить:

Платформа надає безкоштовний функціонал і розширені можливості за підпискою.

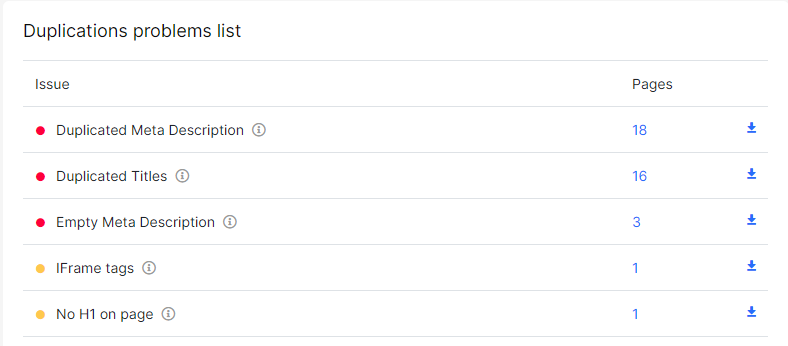

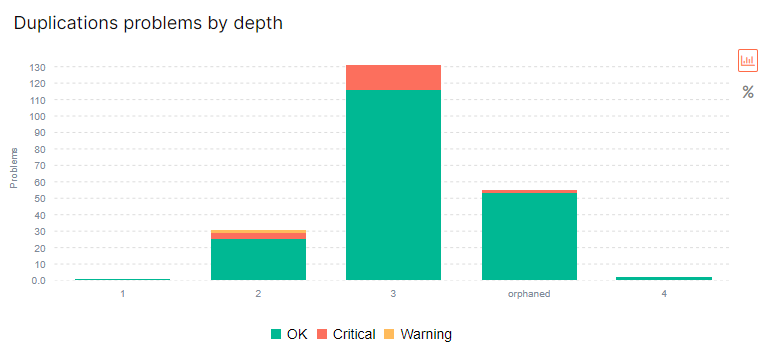

Платформа також дозволяє виявити помилки на сайті, в тому числі й дублі. Для цього необхідно зареєструватися на сайті, додати проект (безкоштовно для трьох проектів, більше - за невелику плату) і запустити сканування веб-ресурсу.

Сервіс працює за схожим принципом, проте допомагає виявити, також, і смислові дублікати. Це сторінки зі схожим, але унікально прописаним контентом.

Платформа пропонує безкоштовну пробну версію, і подальше користування за обраним тарифним планом.

Програми парсингу - це одна з найбільш частих рекомендацій щодо того, як знайти дублікати сторінок на сайті пошуковому оптимізаторові.

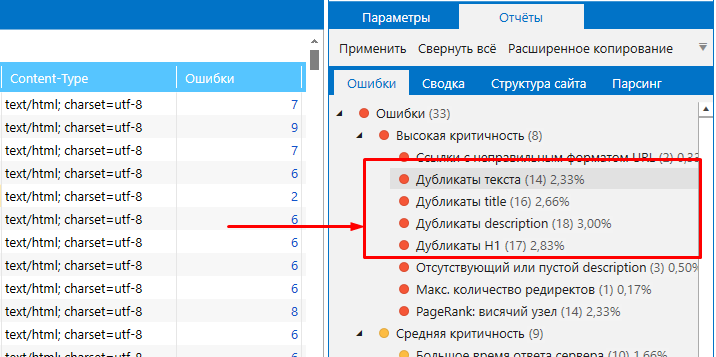

Netpeak Spider допоможе провести повний аудит ресурсу і виявити 62 помилки в 54 параметрах, серед яких - дублі. Шляхом сканування можна знайти сторінки з клонованим змістом: повні дублі, копії сторінок за контентом блоку <body>, дубльовані теги «Title» і метатеги «Description».

Підходить навіть для великих проектів.

Screaming Frog Seo Spider використовується для невеликих і середніх веб-ресурсів. Десктопна програма сканує сайт на наявність повних і часткових дублів, повторюваних назв, заголовків, мета-даних.

Безкоштовна програма Xenu Link Sleuth також проводить техаудит і знаходить повні копії, в т.ч. і заголовків. Однак, фрагментні дублі вона не виявляє.

Перед тим, як дізнатися кількість сторінок на сайті, необхідно встановити програму, прописати адресу сайту в рядок введення, провести сканування, в напівавтоматичному режимі впорядкувати результати та порівняти збіги.

Пам'ятайте, що перевірка на наявність дублів - це лише половина справи. Після виявлення помилок їх необхідно усунути.

Отже, підходимо до завершального етапу: як прибрати дублікати пріоритетних сторінок? Методів кілька.

Найбільш очевидний - видалити клони сторінок зі слешем і іншими фрагментами URL, які генерують дублі. Також можна заборонити роботам додавати в індекс копії, вписавши відповідні умови в файл "robots.txt". Цей метод актуальний для службових сторінок, які повторюють контент основних.

Ще одне рішення - налаштувати 301 редирект зі сторінки-дубля на пріоритетну сторінку сайту. Це допоможе з помилками в ієрархії розділів і reff-мітками.

З налаштованим 301 редіректом роботи бачать, що за конкретною адресою сторінка більше не доступна і перенесена на інший URL. Так вага з дубльованої сторінки перенаправиться на пріоритетну.

Також видалення дублів можна здійснити, проставивши тег "rel=canonical". Це вирішить проблему з пагінацією, угрупованнями та фільтрами.

А якщо проблема пов'язана з версіями для друку і блоками з коментарями та відгуками, скористайтеся тегом:

Це дозволить приховати подібні блоки від роботів пошукових систем.

Мы свяжемся с вами в ближайшее время!

Ми зв'яжемося з вами найближчим часом!